OpenAI o3-mini

OpenAI a récemment dévoilé sa dernière avancée en matière d’intelligence artificielle : le modèle o3-mini. Ce nouveau modèle est conçu pour repousser les limites du raisonnement rentable, offrant des capacités améliorées dans les domaines des sciences, de la technologie, de l’ingénierie et des mathématiques (STEM). Disponible à la fois dans ChatGPT et via l’API d’OpenAI, o3-mini vise à offrir des performances exceptionnelles tout en maintenant de faibles coûts et une latence réduite.

Caractéristiques et capacités clés

- Optimisation STEM : Le modèle o3-mini est optimisé pour les applications STEM et démontre des performances supérieures à celles du modèle o1 sur les benchmarks scientifiques, mathématiques et de codage.

- Niveaux de raisonnement : Le modèle prend en charge trois niveaux de raisonnement (faible, moyen et élevé), qui contrôlent le nombre de jetons qu’il génère pendant sa phase de “réflexion” lors de la génération d’une réponse.

- Recherche Web : L’o3-mini peut rechercher sur le Web pour fournir des réponses basées sur des informations actuelles.

- Fonctionnalités des développeurs : Le modèle prend en charge les appels de fonctions, les sorties structurées et les réponses en continu. Il inclut également les messages des développeurs, qui font partie de la hiérarchie d’instructions d’OpenAI qui aide à se protéger contre les jailbreaks.

- Pas de fonctionnalités de vision : L’o3-mini n’a pas de fonctionnalités de vision, il ne peut donc pas répondre aux questions sur les images.

En complément, OpenAI o3, une version plus puissante, excelle dans les analyses complexes, offrant des performances supérieures pour des tâches exigeantes.

Améliorations des performances

OpenAI a optimisé o3-mini pour le raisonnement STEM. Avec un effort de raisonnement moyen, o3-mini correspond aux performances du modèle o1 en mathématiques, en codage et en sciences, tout en fournissant des réponses plus rapides. Les évaluations par des testeurs experts ont montré que o3-mini produit des réponses plus précises et plus claires, avec des capacités de raisonnement plus fortes, que le modèle o1-mini précédent.

Les testeurs ont préféré les réponses d’o3-mini à o1-mini 56 % du temps et ont observé une réduction de 39 % des erreurs majeures sur des questions difficiles du monde réel. Avec un effort de raisonnement moyen, o3-mini correspond aux performances d’o1 sur certaines des évaluations de raisonnement et d’intelligence les plus difficiles, y compris l’American QA Invitational Mathematics Examination (AIME) et le Graduate Physics Qualifying Assessment (GPp).

Disponibilité et accès

À partir d’aujourd’hui, o3-mini est déployé dans l’API Chat Completions, l’API Assistants et l’API Batch pour sélectionner les développeurs dans les niveaux d’utilisation de l’API 3-5.

Les utilisateurs de ChatGPT Plus, Team et Pro peuvent accéder immédiatement à o3-mini, l’accès Entreprise étant prévu pour février. Le modèle remplacera l’ancien o1-mini dans le sélecteur de modèles, offrant des limites de débit plus élevées et une latence plus faible, ce qui en fait un choix convaincant pour les tâches de codage, de STEM et de résolution de problèmes logiques.

Dans le cadre de cette mise à niveau, OpenAI triple la limite de débit pour les utilisateurs Plus et Team de 50 messages par jour avec o1-mini à 150 messages par jour avec o3-mini.

De plus, o3-mini fonctionne désormais avec la recherche pour trouver des réponses à jour avec des liens vers des sources Web pertinentes. Il s’agit d’un prototype précoce car OpenAI travaille à intégrer la recherche dans ses modèles de raisonnement.

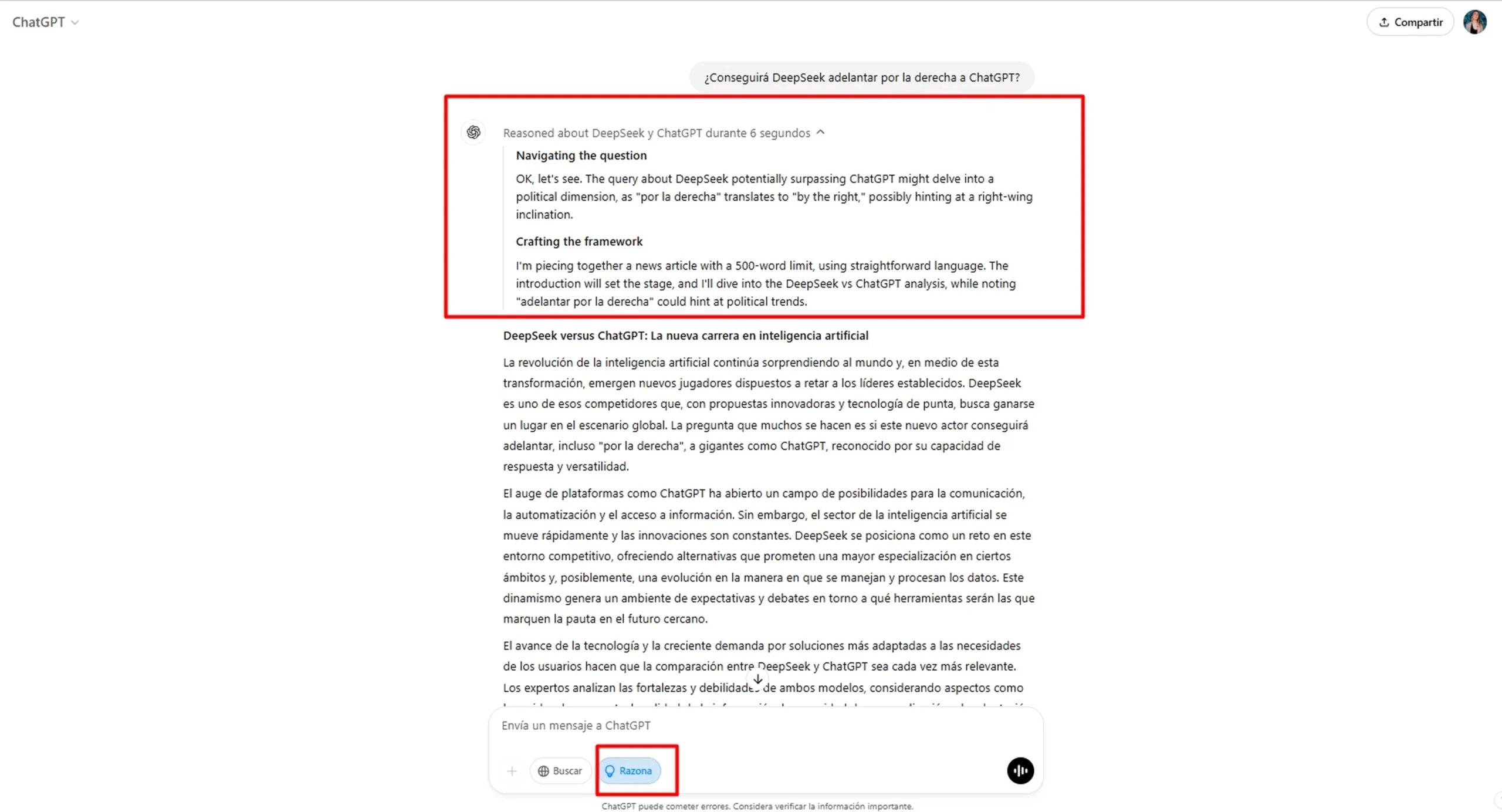

Les utilisateurs de plans gratuits peuvent également essayer o3-mini en sélectionnant “Raison” dans le composeur de messages ou en régénérant une réponse, marquant la première fois qu’un modèle de raisonnement est mis à la disposition des utilisateurs gratuits dans ChatGPT.

Paramètre d’effort de raisonnement

Le modèle o3-mini introduit un paramètre d’effort de raisonnement qui permet aux utilisateurs d’ajuster la charge cognitive du modèle, avec des options pour des niveaux de raisonnement faibles, moyens ou élevés.

Un faible niveau de raisonnement peut convenir à des tâches de traitement de données simples, tandis qu’un niveau élevé peut être utilisé pour des processus décisionnels complexes.

Intégration avec GitHub Copilot

Dans un développement significatif, o3-mini a été intégré à GitHub Copilot Free. Cette intégration permet aux développeurs de tirer parti des capacités de raisonnement avancées d’o3-mini directement dans leur environnement de codage.

Le dernier modèle d’OpenAI, o3-mini, est le modèle le plus rentable de leur série de raisonnements. o3-mini surpasse o1 sur les benchmarks de codage avec des temps de réponse comparables à o1-mini, ce qui signifie que vous obtiendrez une qualité améliorée à presque la même latence.

Le modèle est configuré pour utiliser l’effort de raisonnement “moyen” d’OpenAI et peut être consulté dans VS Code et Github.com Copilot aujourd’hui, avec un support à suivre prochainement dans Visual Studio et JetBrains. L’accès à o3-mini est actuellement en préversion et est soumis à la limite de 50 chats gratuits par mois.

Comparaison avec le modèle o1

Le modèle o3-mini surpasse le modèle o1-mini, même à de faibles niveaux de raisonnement, et à des niveaux de raisonnement élevés, il surpasse le modèle o1 complet sur plusieurs benchmarks. Le o3-mini offre des limites de débit plus élevées et une latence plus faible que le o1-mini.