Les derniers modèles d’intelligence artificielle d’OpenAI, o3 et o4-mini, suscitent de vives discussions dans la communauté IA. Malgré leurs avancées remarquables en raisonnement, codage et mathématiques, ces nouveaux modèles affichent des taux d’hallucination nettement supérieurs à ceux de leurs prédécesseurs, remettant en question la fiabilité de l’IA générative de pointe.

Qu’est-ce qu’une hallucination en IA?

Une hallucination désigne une réponse générée par un modèle d’IA qui semble plausible mais qui est factuellement incorrecte ou totalement inventée. Ce phénomène, bien connu dans le domaine des grands modèles de langage, peut résulter d’un manque de données d’entraînement, de biais dans les données ou d’erreurs dans les méthodes d’apprentissage. Les hallucinations posent un risque accru lorsque l’IA est utilisée pour des décisions critiques, par exemple en santé ou en finance.

Résultats des tests internes: des chiffres préoccupants

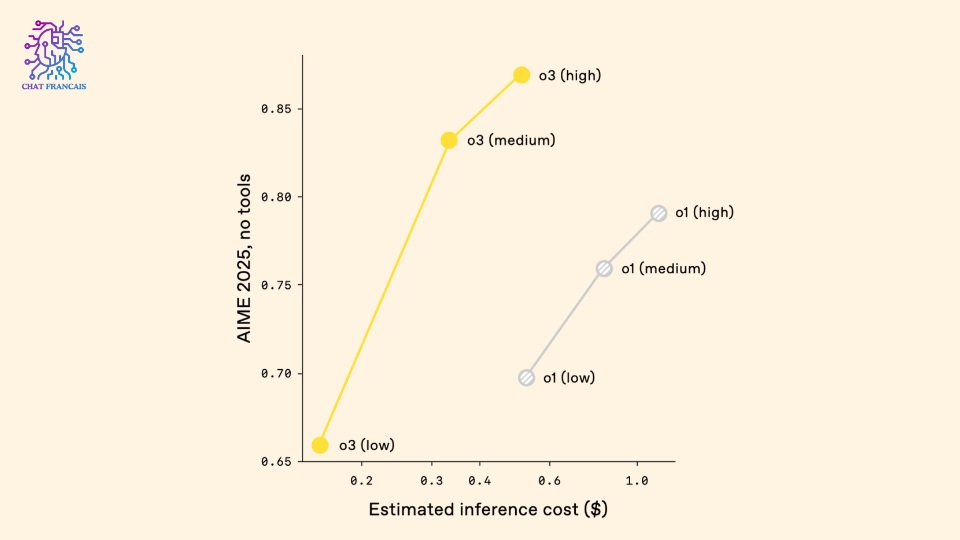

OpenAI a évalué o3 et o4-mini sur son propre benchmark, PersonQA, qui mesure la capacité du modèle à répondre correctement à des questions factuelles sur des personnes. Les résultats sont sans appel :

- o3 hallucine dans 33 % des cas, soit plus du double du taux observé sur les modèles antérieurs comme o1 et o3-mini (16 %).

- o4-mini atteint un taux d’hallucination record de 48 %, tout en affichant une précision globale inférieure (36 % contre 59 % pour o3 sur le même benchmark).

| Modèle | Précision (PersonQA) | Taux d’hallucination |

| o1 | 47% | 16% |

| o3 | 59% | 33% |

| o4-mini | 36% | 48% |

Pourquoi cette augmentation des hallucinations?

Contrairement à la tendance observée jusqu’ici, où chaque nouvelle génération de modèles réduisait progressivement les hallucinations, o3 et o4-mini inversent cette dynamique. OpenAI admet ne pas comprendre pleinement les causes de cette hausse et souligne la nécessité de recherches approfondies.

Plusieurs hypothèses émergent :

- Les méthodes de reinforcement learning utilisées pour la série o pourraient amplifier certains défauts habituellement corrigés lors de l’entraînement postérieur.

- Le fait que o3 génère davantage d’affirmations, correctes ou non, augmente mécaniquement le nombre de réponses erronées.

- La taille réduite de o4-mini expliquerait ses performances moindres, les petits modèles disposant de moins de connaissances générales.

Impacts concrets et réactions de la communauté

Cette hausse des hallucinations soulève des inquiétudes pour les usages réels de l’IA. Par exemple, des tests indépendants ont montré que o3 pouvait inventer des actions qu’il prétend avoir réalisées, comme des recherches web fictives ou l’exécution de scripts inexistants. De plus, certains utilisateurs rapportent que le modèle génère fréquemment des liens web cassés ou non fonctionnels.

Des experts comme Kian Katanforoosh (Stanford, Upwork) reconnaissent la supériorité de o3 sur certains aspects mais déplorent la fiabilité amoindrie des réponses, notamment pour le développement web ou la recherche d’informations.

Perspectives et enjeux pour l’avenir de l’IA générative

L’augmentation des hallucinations dans les modèles les plus récents d’OpenAI met en lumière les défis persistants de l’IA générative. Si les performances brutes progressent (raisonnement, mathématiques, analyse visuelle), la fiabilité factuelle stagne, voire recule.

OpenAI appelle à une mobilisation de la recherche pour comprendre et corriger ce phénomène. Pour les professionnels de l’IA, la vigilance s’impose : il reste essentiel de vérifier les réponses générées, en particulier dans les contextes sensibles ou réglementés.

En résumé

Les modèles o3 et o4-mini d’OpenAI marquent une avancée technique mais révèlent une fragilité inquiétante sur le plan de la véracité. La lutte contre les hallucinations reste un défi central pour l’IA de demain, et la communauté attend des solutions concrètes pour garantir la fiabilité des systèmes déployés.